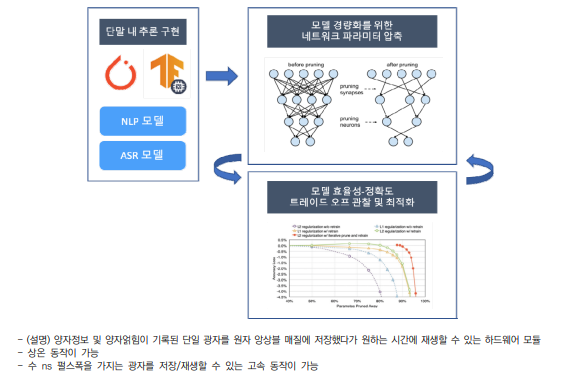

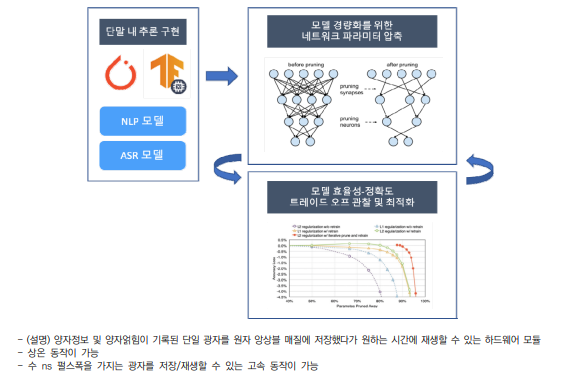

1. 기술의 개념 최근 개인정보 보호를 위해 사용자의 데이터를 서버로 보내지 않고 머신러닝 모델을 사용 하기 위한 단말 내 인공지능 모델 추론의 필요성이 커지고 있음 다만, 인공신경망을 이용한 애플리케이션들은 높은 연산량을 요구. 모델 자체가 포함하는 네트워크 구조 및 네트워크 내 파라미터가 차지하는 디바이스 내 저장 공간을 포함하여, 추론 연산이 일어날 시 소모하는 메모리 및 CPU 자원이 일반적인 애플리케이션의 연산량 에 비해 크다는 문제가 있음이러한 문제는 대부분의 휴대폰 단말에서 리소스 사용량을 초과하여 앱이 실행되지 못하 고 종료되는 현상을 불러옴 본 기술은 단말 내에서 인공신경망 모델을 구동하기 위한 모델 경량화를 다룸 인공신경망 모델의 연산 오버헤드는 신경망 내 총 파라미터 개수에 비례하며, 이는 추론 시 사용되는 컴퓨팅 파워 및 메모리에 큰 영향을 미침 따라서 본 기술은 기본적으로 모델의 용량 및 연산량을 줄이기 위해 인공신경망 레이어 및 노드 중 일부를 줄여 파라미터의 총 수를 줄이는 방법을 채택. 인공신경망 사이의 시냅 스 연결 중 상대적으로 의사결정에 영향을 적게 주는 시냅스 연산을 생략하는 방법을 사용 이러한 방법을 통해 레이어 노드 및 시냅스를 줄인 경우 그에 따라 인공신경망 모델이 가지는 추론의 복잡도 또한 떨어지게 됨. 추론에 있어서 데이터 내의 복잡도가 높은 정보 의 해석이 요구될 경우, 인공신경망 복잡도가 낮아짐에 따라 모델 전체의 성능이 저하되는