| 제목 | [산업분석] 휴머노이드 로봇 지능형 제어·모션 학습 최신 연구 |

|---|

| 분류 | 성장동력산업 | 판매자 | 국준아 | 조회수 | 73 | |

|---|---|---|---|---|---|---|

| 용량 | 1.11MB | 필요한 K-데이터 | 8도토리 |

| 파일 이름 | 용량 | 잔여일 | 잔여횟수 | 상태 | 다운로드 |

|---|---|---|---|---|---|

| 1.11MB | - | - | - | 다운로드 |

| 데이터날짜 : | 2025-09-11 |

|---|---|

| 출처 : | 국책연구원 |

| 페이지 수 : | 16 |

I. 서론

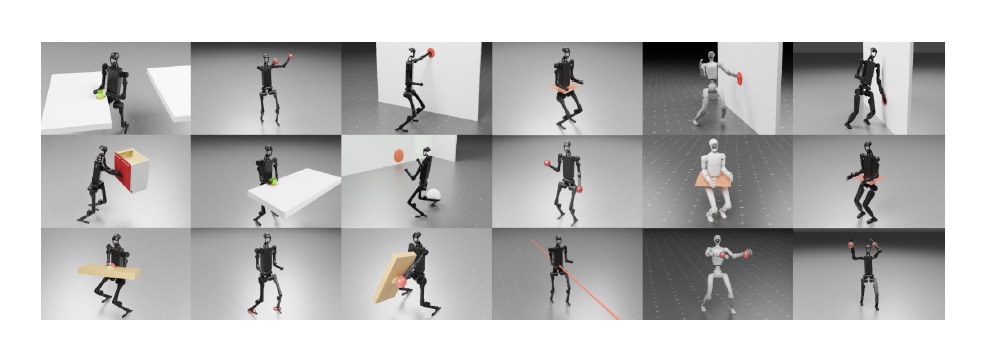

휴머노이드 로봇은 인간과 유사한 형태와 관절 구조를 가져서 사람과 같은 환경에서 보행하고 물체를 다루며 다양한 작업을 수행할

잠재력이 있다[1][2]. 그러나 인간 수준의 유연하고 능숙한 동작을 휴머노이드에 구현하기 위해서는 모션 생성부터 하위 레벨 제어

그리고 고난이도 스킬 학습에 이르는 복합적인 기술이 요구된다. 과거 수십 년간 휴머노이드의 보행과 모션 제어는 모델 기반 제어와

계획에 주로 의존해 왔다. 하지만 모델기반 기법은 접촉 불확실성이나 고차원 동역학을 가진 휴머노이드의 전신 제어에 한계가 있으며, 새로운 동작 하나하나를 설계ㆍ튜닝해야 하는 어려움이 있다[3].

II. 주요 기술 동향

1. 강화학습을 활용한 휴머노이드 제어 기술

초창기 휴머노이드 강화학습 연구에서는 학습에 매우 오랜 시간과 자원이 소모되었으며 훈련이 불안정한 문제가 있었지만,

최근에는 알고리즘과 병렬 시뮬레이션의 발전으로 학습 효율이 비약적으로 향상되고 있다.

예를 들어, 2025년에는 기존 TD3(Twin Delayed DDPG) 알고리즘을 개량한 FastTD3가 제안되어 병렬 환경과 대용량 배치 분포형 비평가 등을 통해 휴머노이드 동작 학습을 크게 가속화 하였다[12].

그 결과 단일 GPU로 불과 3시간 만에 다양하고 안정적인 보행ㆍ조작 정책을 얻어냈으며, 기존 강화학습 기법 대비 훈련 시간을

획기적으로 단축하였다.

한편, 모델 기반 정보를 활용하여 강화학습을 돕는 시도도 활발하다. 예를 들어, 최적 제어 기법으로 생성한

동작 데이터셋을 강화학습 정책의 참조로 활용하는 프레임워크 Opt2Skill이 최근에 선보여졌다[3].

구체적으로는 미분 동적 프로그래밍으로 휴머노이드의 실현 가능한 궤적을 계산하고, 강화학습으로 이를 추종하게 함으로써

모션 캡처 데이터 없이도 계단 오르기, 문 열기, 울퉁불퉁한 지형 걷기 등 다양한 전신 동작을 높은 성공률로 수행했다.

이와 유사하게 궤적 최적화와 강화학습을 혼합한 구조의 AMO (Adaptive Motion Optimization)는 먼저 궤적 최적화로

예비 동작을 만들고 강화학습으로 온라인으로 적응시키는 기법을 제안하였다[13].

그 결과 강화학습만으로 학습한 정책보다 안정성과 명령 대응력이 향상되었고,

실제 Unitree G1 로봇에의 이식도 성공하였다.

---------------------------------------------------------------------------------------------------------------------------------------------------------

※ 본 서비스에서 제공되는 각 저작물의 저작권은 자료제공사에 있으며 각 저작물의 견해와 DATA 365와는 견해가 다를 수 있습니다.